機械学習

パソコンに多種多様な仕事を行ってもらうために人間が全てを用意するのは大変で、教えることが難しいことも多いのが実情です。

機械学習によってある程度指針を人間で示しながら自動でパソコンに賢くなってもらい、ときには人間を凌駕するような性能を発揮してもらいます。

2017.9.3

-

474Views

-

1Watch

-

96Knows

-

一つ上へ

-

DeepLearning近年注目されている機械学習技術の一つです。ハードウェアの高性能化により以前できなかったような学習ができるようになったことも影響しています。 画像認識、音声認識、時系列データ処理、強化学習、分類、回帰等を行う多層ニューラルネットワークです。

-

決定木学習決定木学習

-

ニューラルネットワーク人間の脳のニューロンモデルから発想を得た教師あり機械学習技術です。1960年から研究が盛んになった非常にメジャーな技術です。 ニューラルネットワーク3度目の黄金期として、今最も注目されているDeepLearningの基礎技術でもあります。

-

SVM見たことないデータに対しても性能を発揮する識別能力をもつ機械学習技術の一つです。Deep Learningが流行る現在でも少数の学習データで性能を発揮することと学習が早いことで現在でも使用されることの多い技術です。

-

クラスタリング教師なし学習の一種で、データそのものを使用してそれらを特定のクラスターに分けていく、クラス分類と異なりクラスタリング前にどのようなクラスがあるかはわかっていない。

-

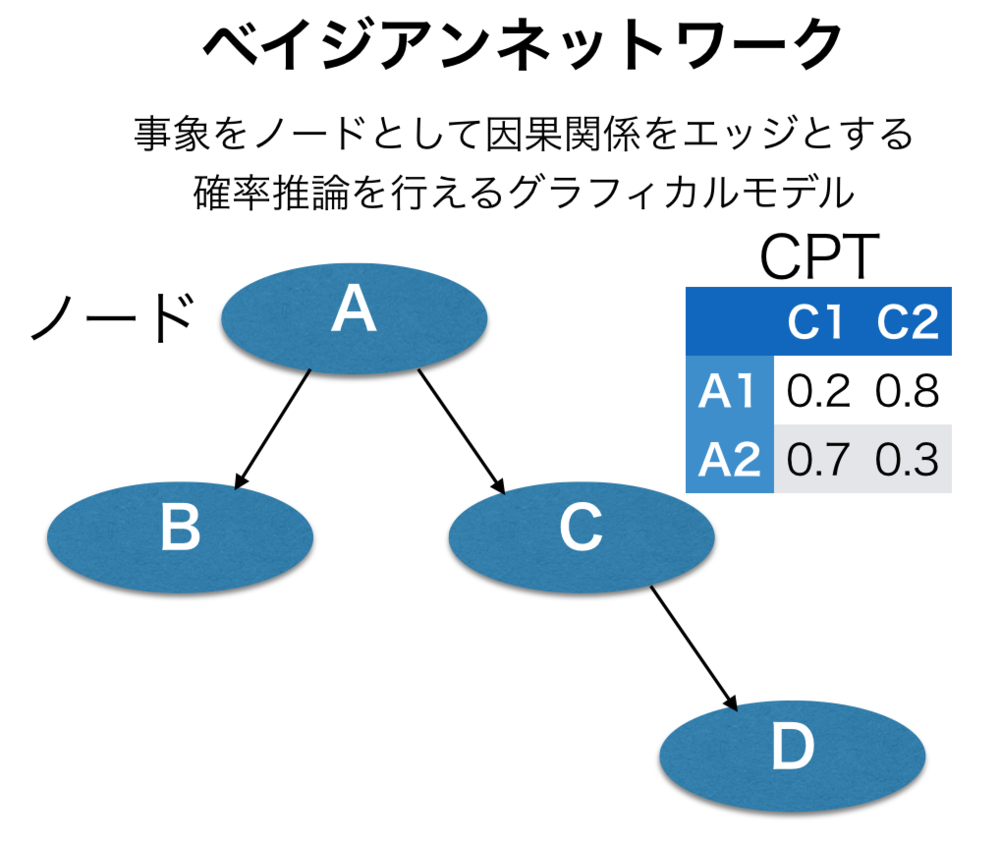

グラフィカルモデルグラフィカルモデルは、各事象を条件付き確率を元に因果関係を視覚的に表現した確率グラフ.論文上で概念の解説時に載せることも多い.

-

性能評価(機械学習)機械学習で学習を終えた学習器の性能を評価する方法についてまとめているページです.

-

その他学習器与えられた特徴量やデータを元に何らかのモデルを生成するその他の学習器についてまとめているページです.

|

|

機械学習の新規投稿

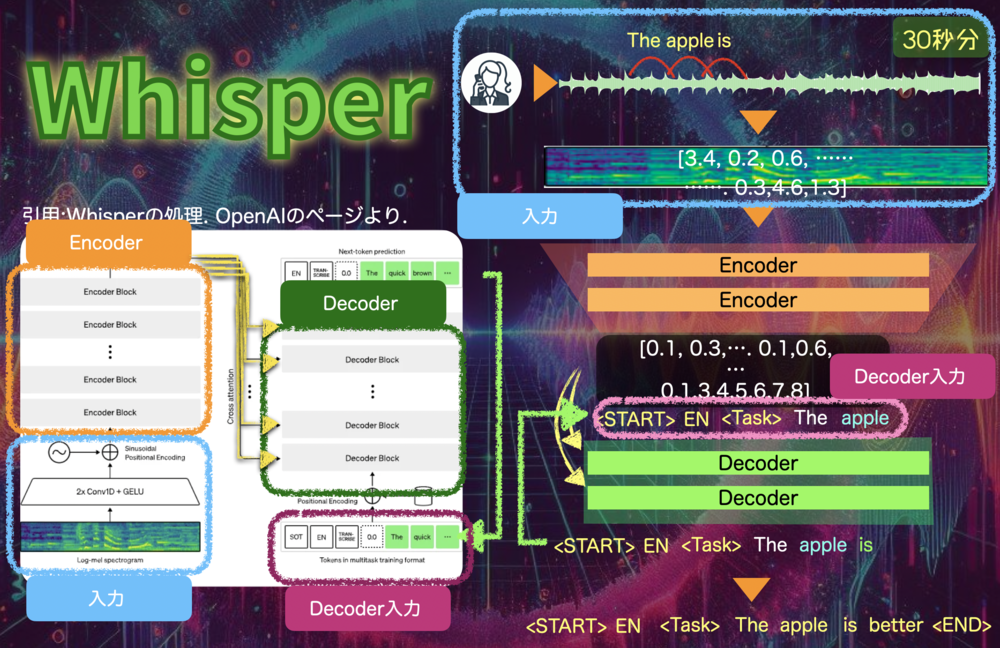

Whisper

WhisperはOpenAIが発表した音声データから文字を読み取る自動音声認識を目的としたAIモデルです.Transformerをベースとしたシンプルな構成で、99言語の文字起こしと翻訳が可能です.モデルサイズごとに性能が異なりますがLargeサイズは人間に遜色ないレベルです.

PV 99

Fav 0

2024.07.06

隠れマルコフモデル

隠れマルコフモデル(HMM, Hidden Markov Model)は、内部の観測できない状態を外部で観測できる状態から推定する技術. 内部の状態は確率でどれかの状態に遷移し、遷移した先で決まった確率で観測される状態を出力する.ビタビアルゴリズムで内部の最も考えられる状態遷移を予測し、Forward-Barckwardアルゴリズムで各時刻、各状態の確率を算出し、BaumWelchアルゴリズムでそもそもモデルのパラメータを推定する.

PV 264

Fav 0

2022.10.11

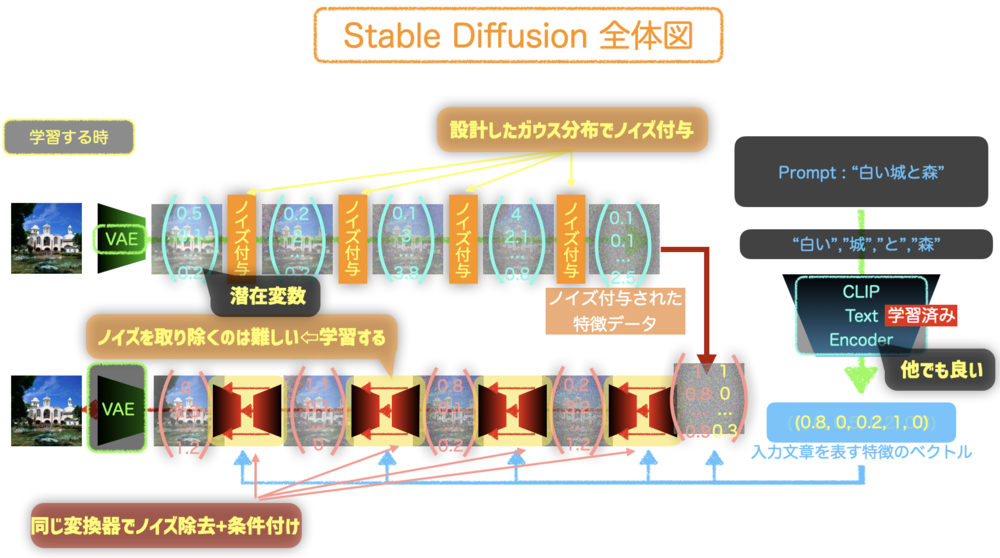

Stable Diffusion

Stable DiffusionはDiffusion Modelをベースとして潜在変数を主に処理しながらユーザのテキスト入力に沿った新しい画像を生成する技術. Stable Diffusionの仕組みを簡単に紹介する.

PV 344

Fav 0

2022.09.05

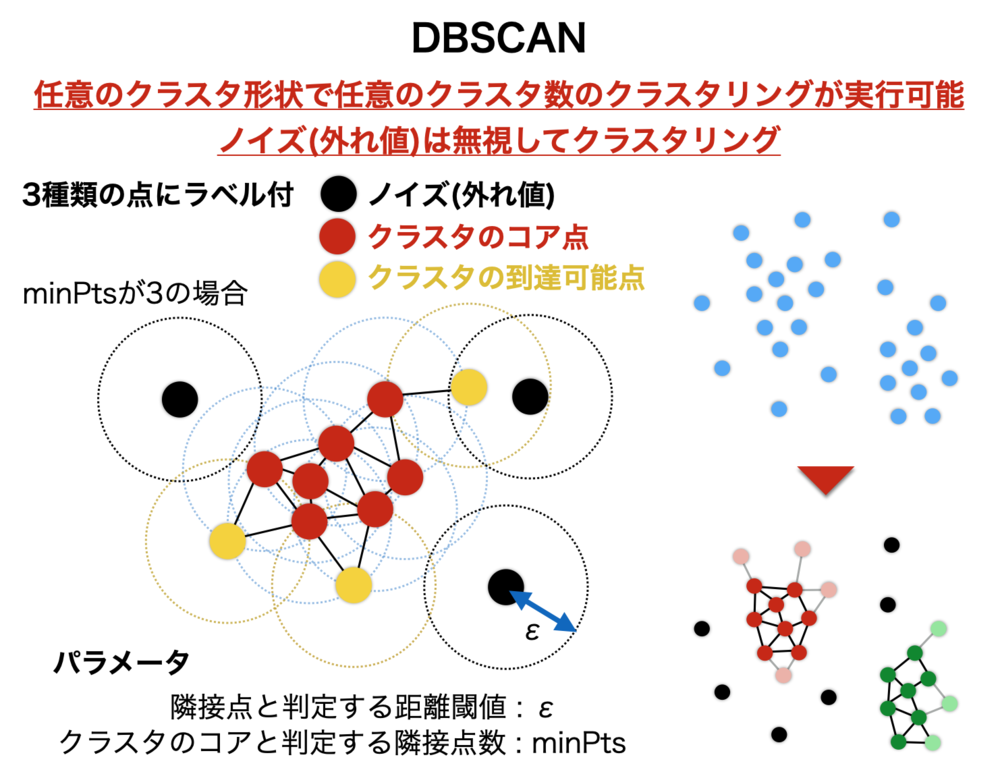

DBSCAN

DBSCAN(Density-based spatial clustering of applications with noise)は主に密度の高い箇所と低い箇所の違いでどんなクラス数でどんな形状でもクラスタリング可能な手法. k-meansと違い予めクラスタ数は不要で線形分離できないクラスタリングも可能.

PV 373

Fav 1

2020.08.29

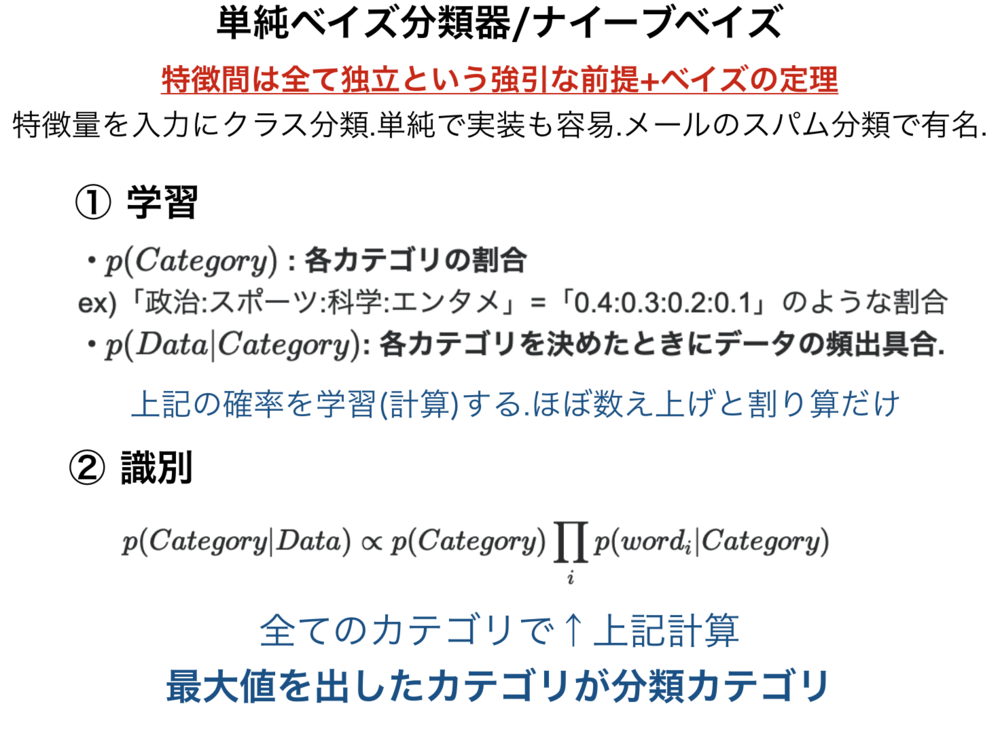

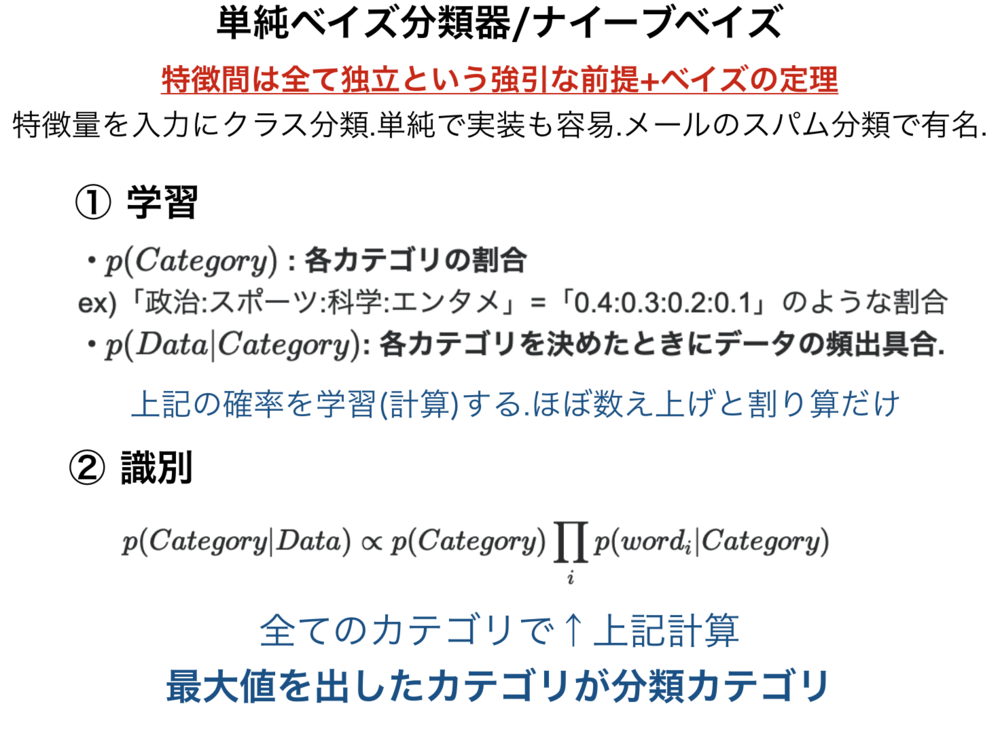

単純ベイズ分類器

単純ベイズ分類器(ナイーブベイズ)は、特徴間は全て独立という強引な前提を置き、ベイズの定理を使用することで、特徴量を入力にクラスを分類する分類器.単純で実装も容易ではあるが、一部のアプリケーションで十分に働く.メールのスパム分類で使用されたことで有名.

PV 608

Fav 0

2019.03.04

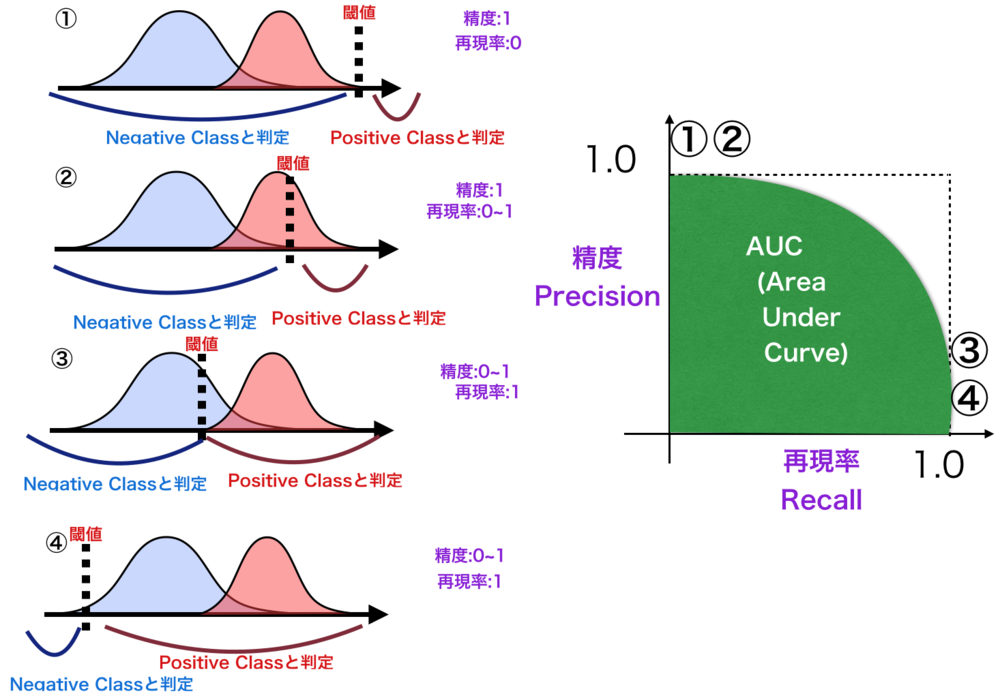

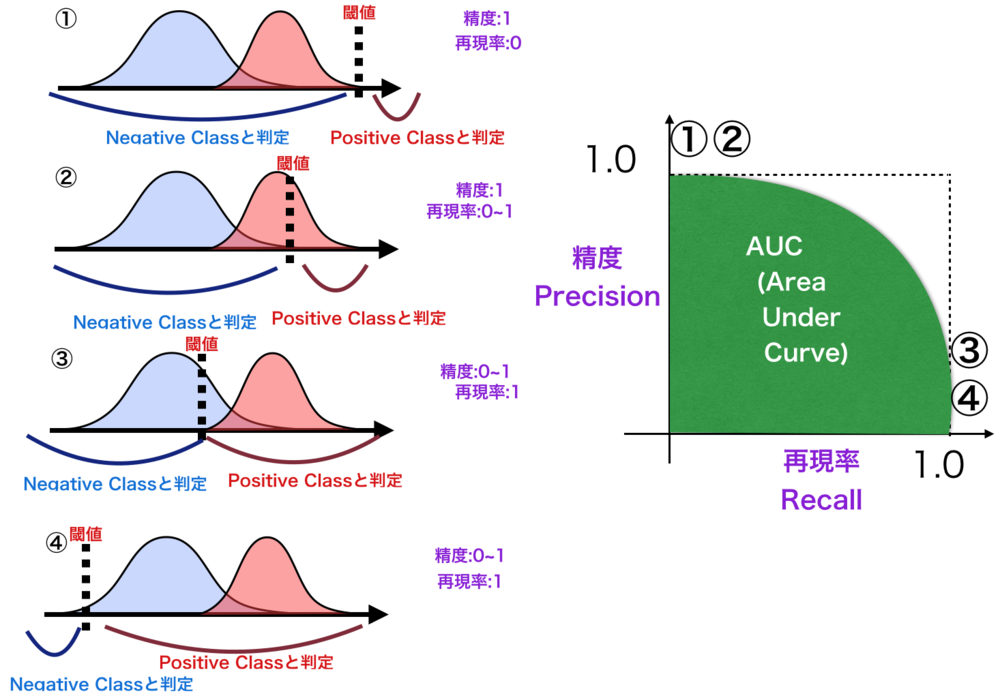

PR曲線

PR曲線(Precision-Recall Curve)は、2クラスの分類の評価指標を与える曲線で、精度(Precision)と再現率(Recall)を軸にプロットしたグラフ.理想的な状態は右上に曲線が張り付く状態.大方ROC曲線と同じだが、ROC曲線より注目データに偏りがあって少ないデータしかないクラスがあるときに有用.

PV 1062

Fav 1

2019.02.07

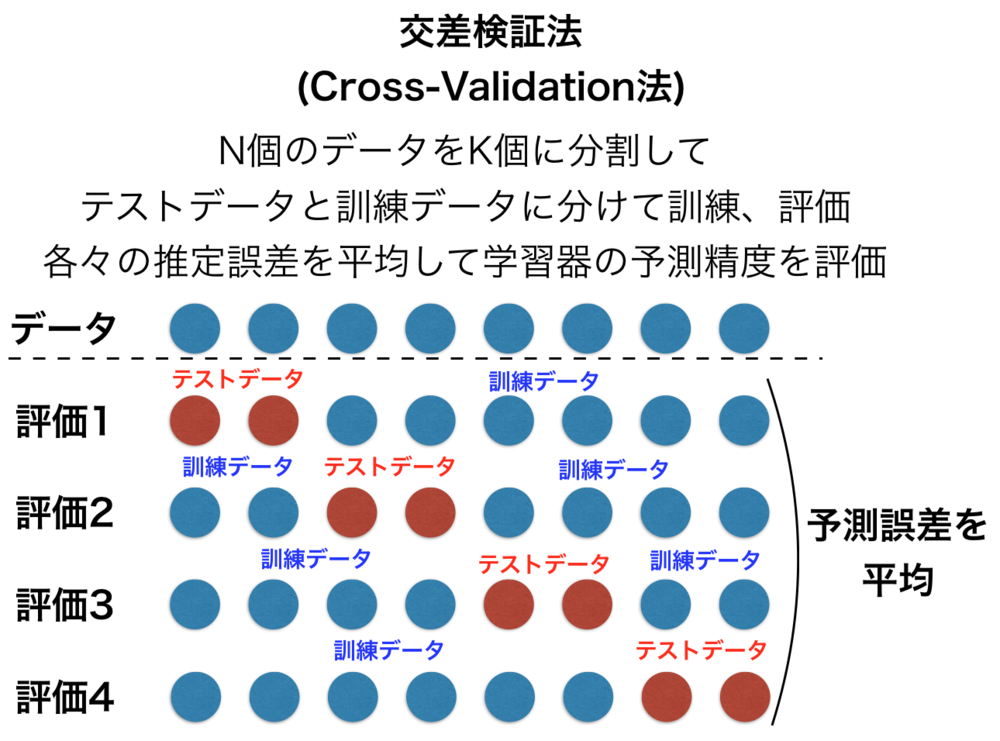

交差検証法

データが少ない時には学習器の推定精度を適切に評価しにくいため、工夫が必要となります.交差検証法(Cross Validation法)は、一部を訓練データとして他をテストデータとした評価を何度か行い、どのデータもテストデータとも訓練データとも使用して評価をすることで予測誤差、推定精度をより正確にする手法です.

PV 388

Fav 1

2019.02.01

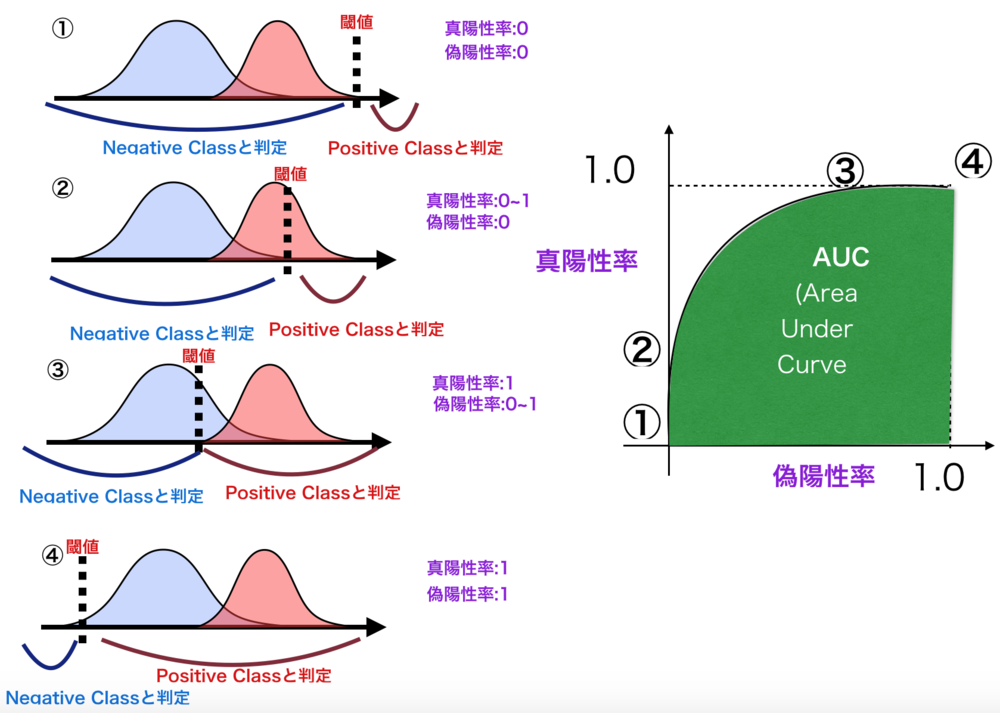

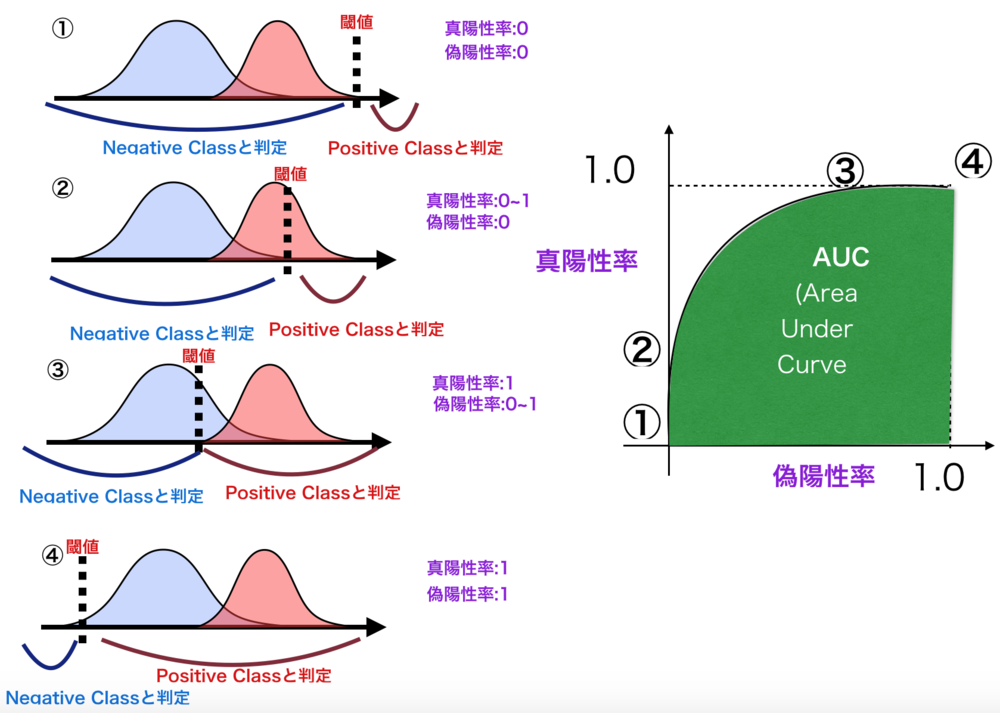

ROC曲線

ROC曲線(受信者操作特性, Receiver Operating Characteristic)は、2クラスの分類の評価指標を与える曲線.もともとは信号処理の分野において用いられていたものだが、他分野でも使用されている.ある閾値を変えていく過程で再現率を縦軸、偽陽性率を横軸にプロットしたグラフ.曲線の下側の面積をAUC(Area Under Curve)と呼び、1に近いほどよく、曲線は左上に張り付いている方がよい.

PV 753

Fav 0

2019.01.29

Convolutionの誤差逆伝播

畳み込み層(Convolution層)の誤差逆伝播の計算についてのみまとめているページです.Convolutionの誤差逆伝播では、後続層からの入力と180度回転したConvolution層のパラメータ、順伝播の入力値を使って計算します.

PV 372

Fav 0

2019.01.28

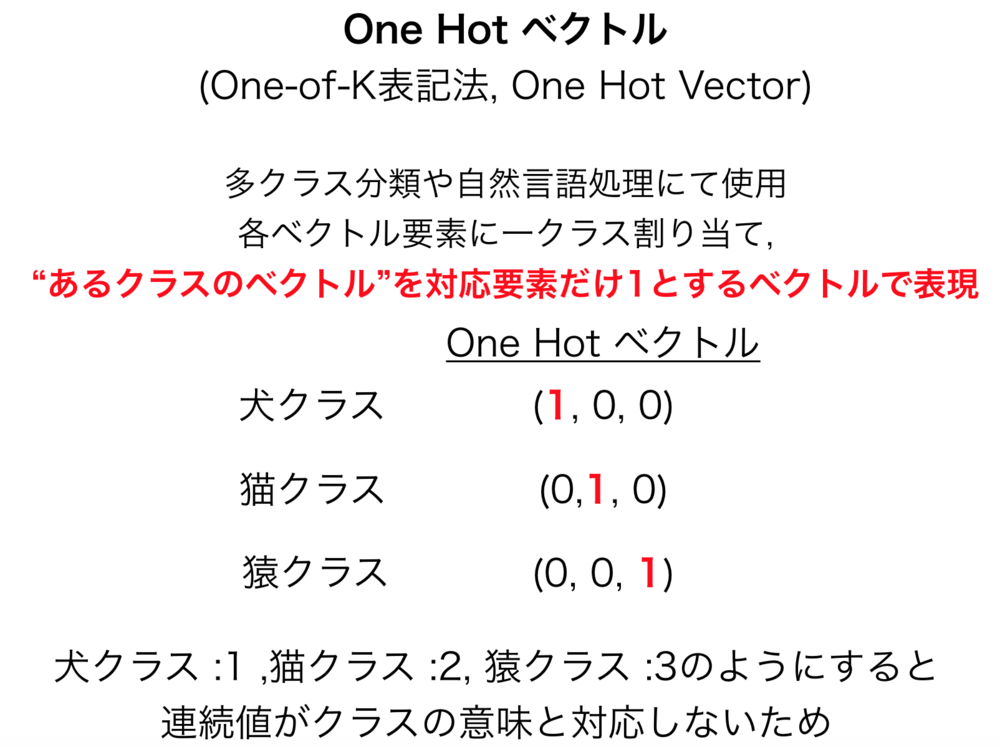

One Hot ベクトル

One Hot ベクトル(One Hot Vector , One-of-K表記法)は、ベクトルの全要素のうち一つだけ1で他は0になっているベクトルをさす.

PV 359

Fav 0

2019.01.10

ベイジアンネットワークとは

ベイジアンネットワークとは、事象の状態や確率などから未知の事象の確率を推定するような確率推定ができる有向非循環なグラフィカルモデルで表現されるネットワーク.各事象が条件付き確率を伴って因果関係で結ばれる形でグラフ表現されている.各事象は原因となっている親ノード以外とは独立であるとされる.離散的な確率が用いられることが多いが連続的な確率も適用可能.

PV 292

Fav 0

2018.12.08

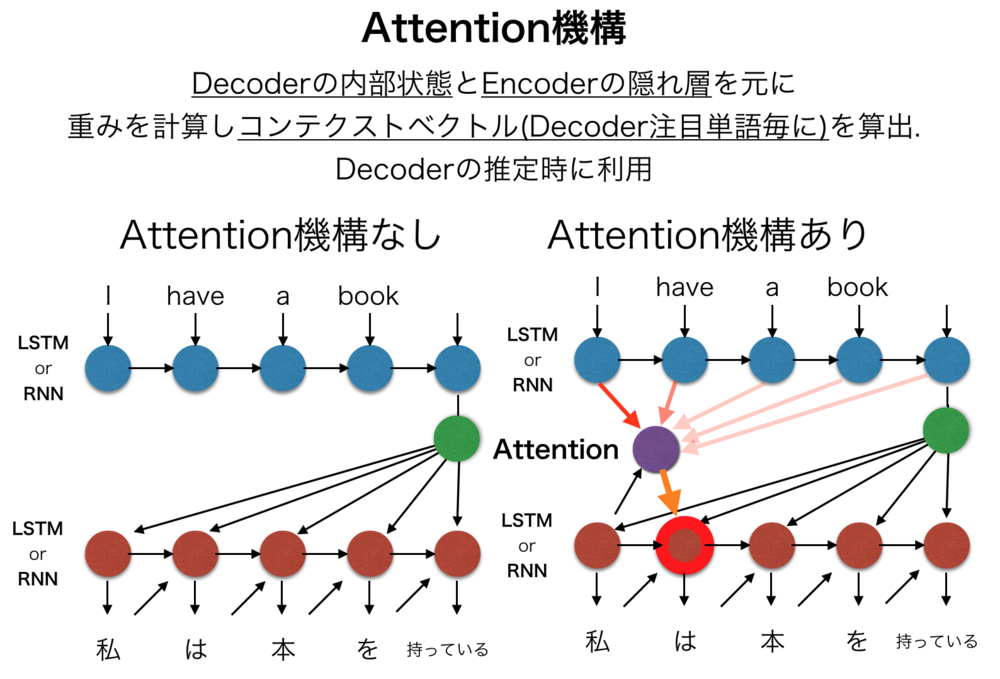

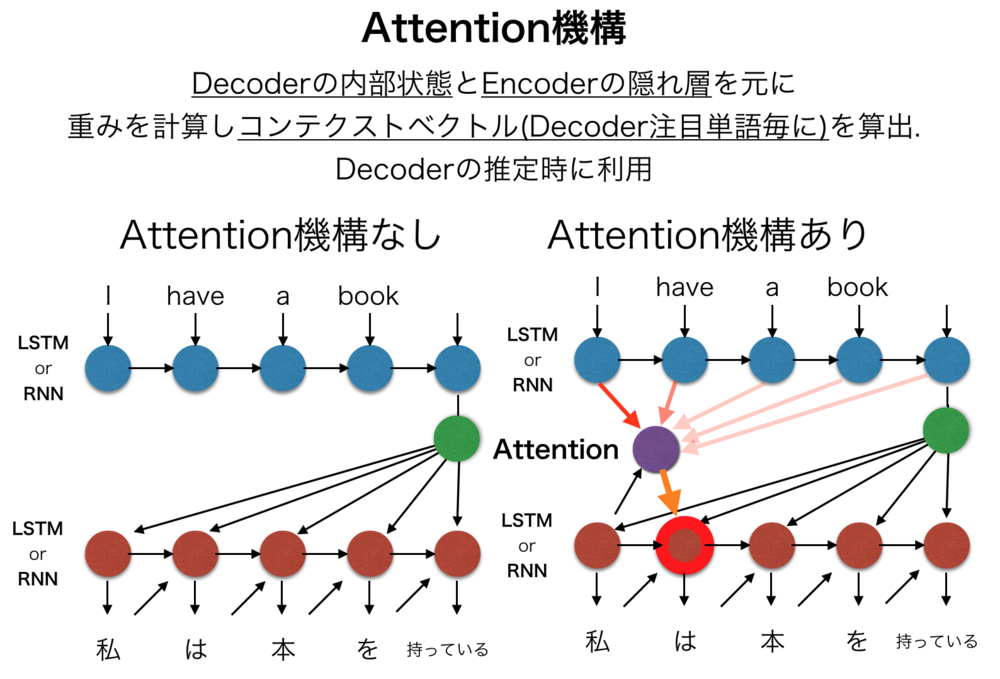

Attention機構

Attention機構(注意機構)とは、主に機械翻訳や画像処理等を目的としたEncoder-Decoderモデルに導入される要素ごとの関係性、注意箇所を学習する機構.機械翻訳において翻訳対象の単語間の関係性や全体のコンテキストを考慮させるために考案されたものだが、画像処理などにおいても応用されている.

PV 1286

Fav 0

2018.12.08

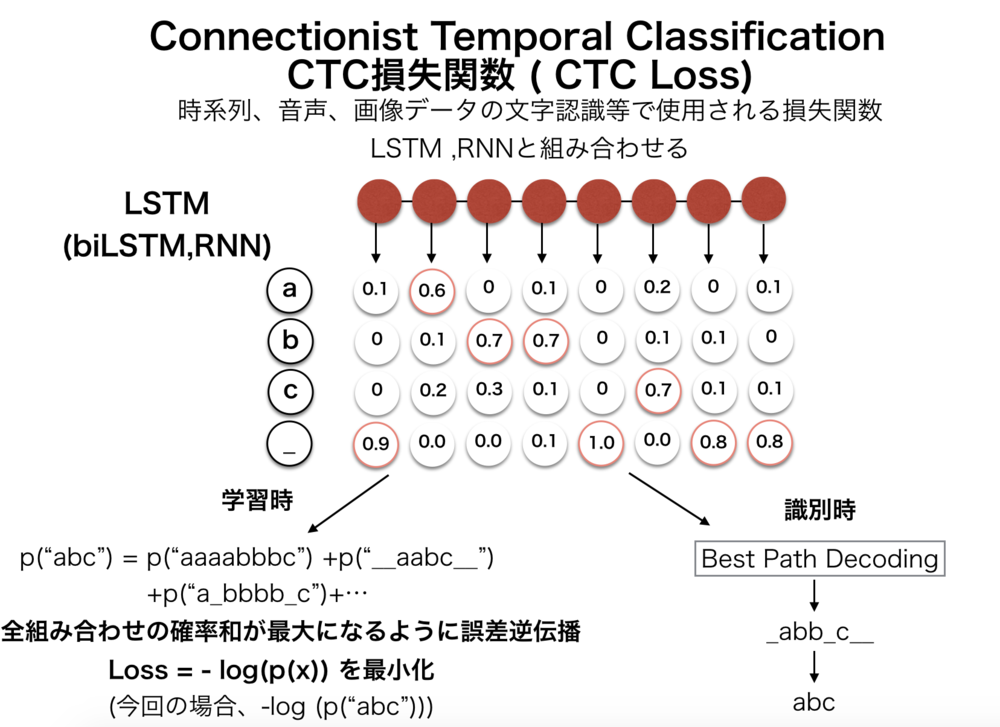

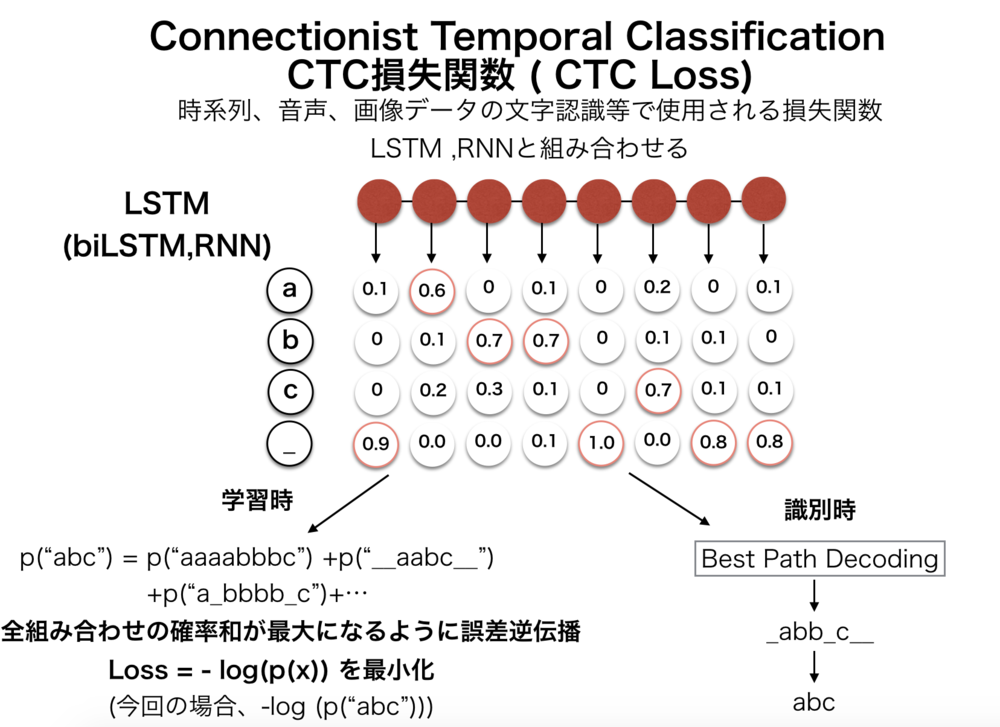

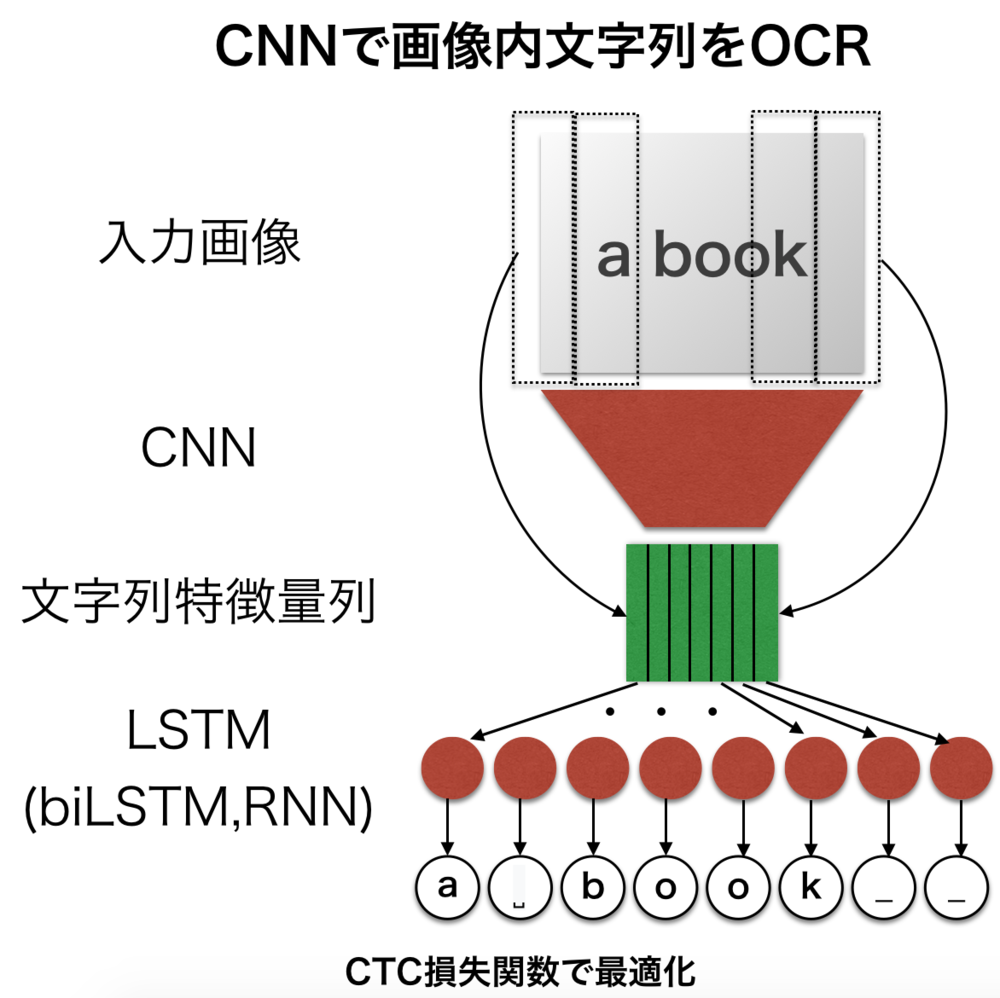

CTC損失関数

CTC Loss(損失関数) (Connectionist Temporal Classification)は、音声認識や時系列データにおいてよく用いられる損失関数で、最終層で出力される値から正解のデータ列になりうる確率を元に計算する損失関数.LSTMやRNNなどの出力を受けて正解文字列の確率を計算する.HMMのように前向き後ろ向きアルゴリズム、動的計画法を元に計算、微分可能であり誤差逆伝播が可能.

PV 1555

Fav 0

2018.12.08

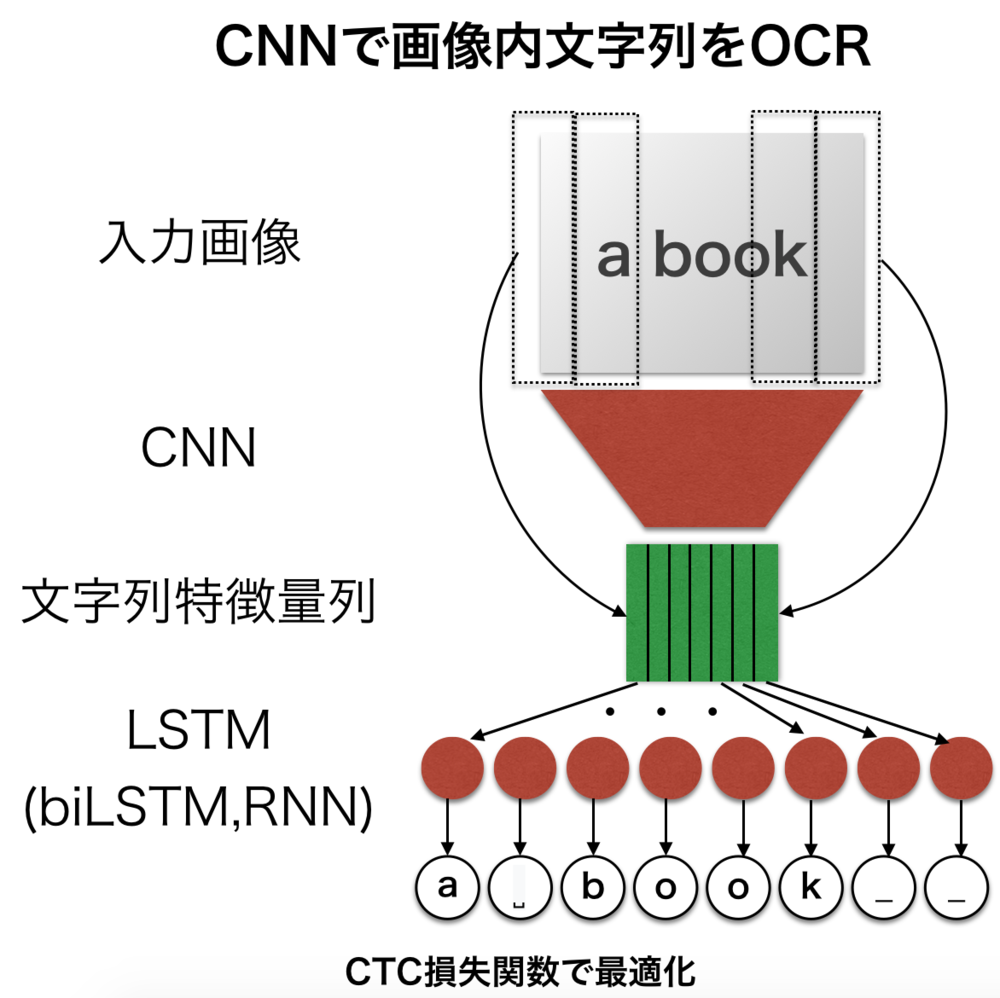

CNNで画像内文字列をOCR

CNNを使って画像の文字列を認識してプログラムで扱える文字列に起こすOCRの例について紹介します.文字列が可変の場合に対応したCNN+LSTMで構成される基本的なネットワークです.

PV 588

Fav 0

2018.12.06

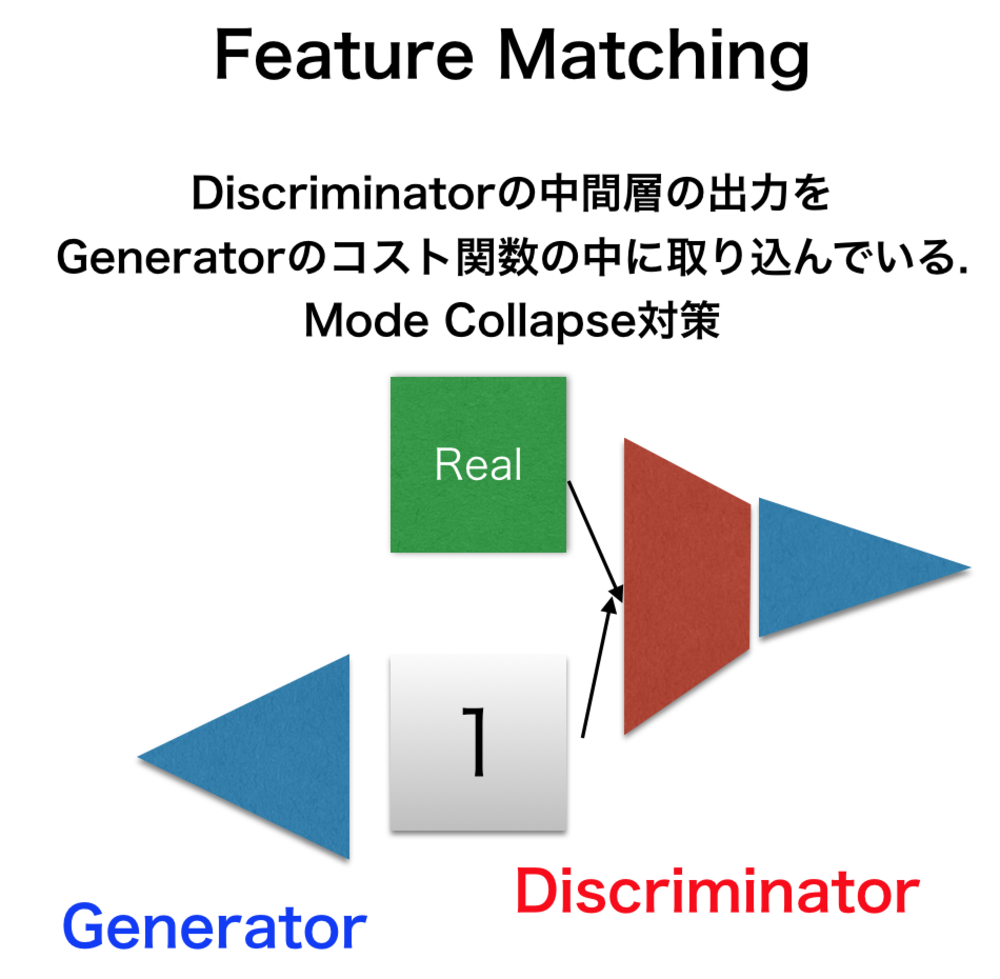

Feature Matching

Feature Matchingとは、GANなどのネットワークで起きるMode Collapseの問題を改善するためにDiscriminatorの中間層を使ってGeneratorのコスト関数を書き換える手法のこと.

PV 221

Fav 0

2018.12.04

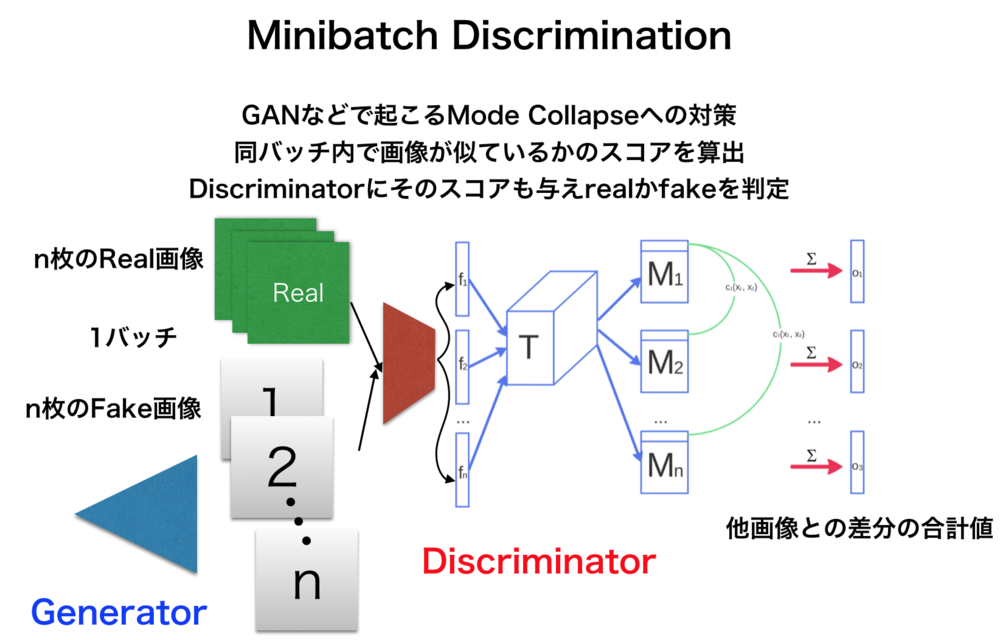

Minibatch Discrimination

Minibatch Discriminationは、GANなどで主に見られるMode Collapseのような問題に対して、複数枚の画像同士が似ているかのスコアをDiscriminatorに与えることで回避する.

PV 283

Fav 0

2018.12.04

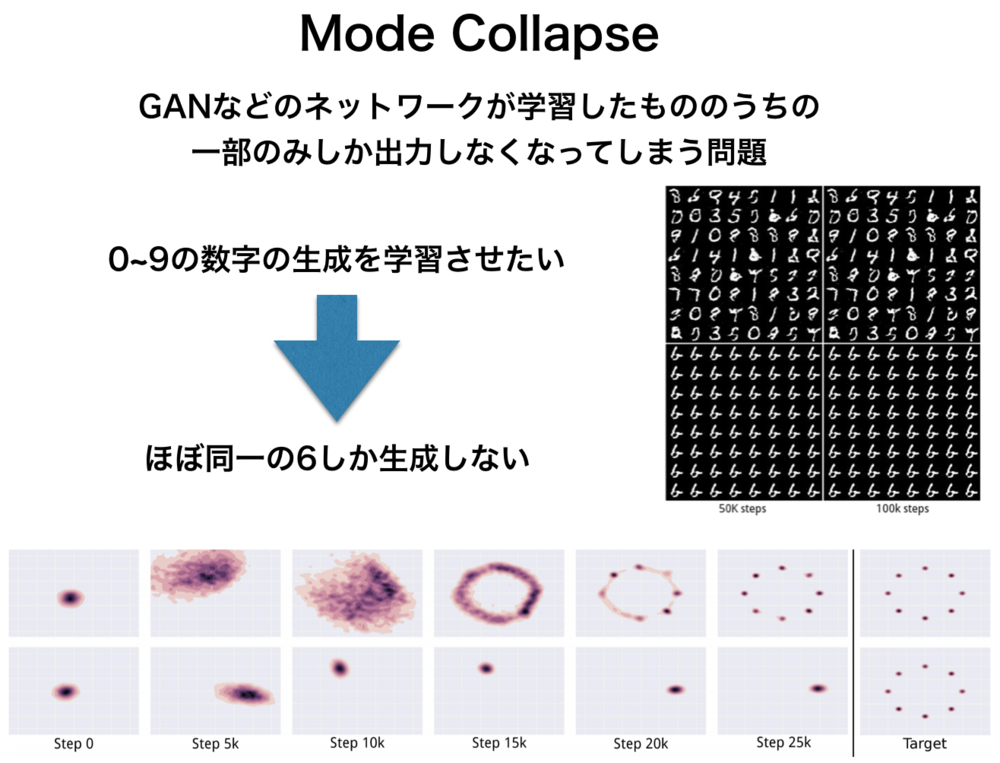

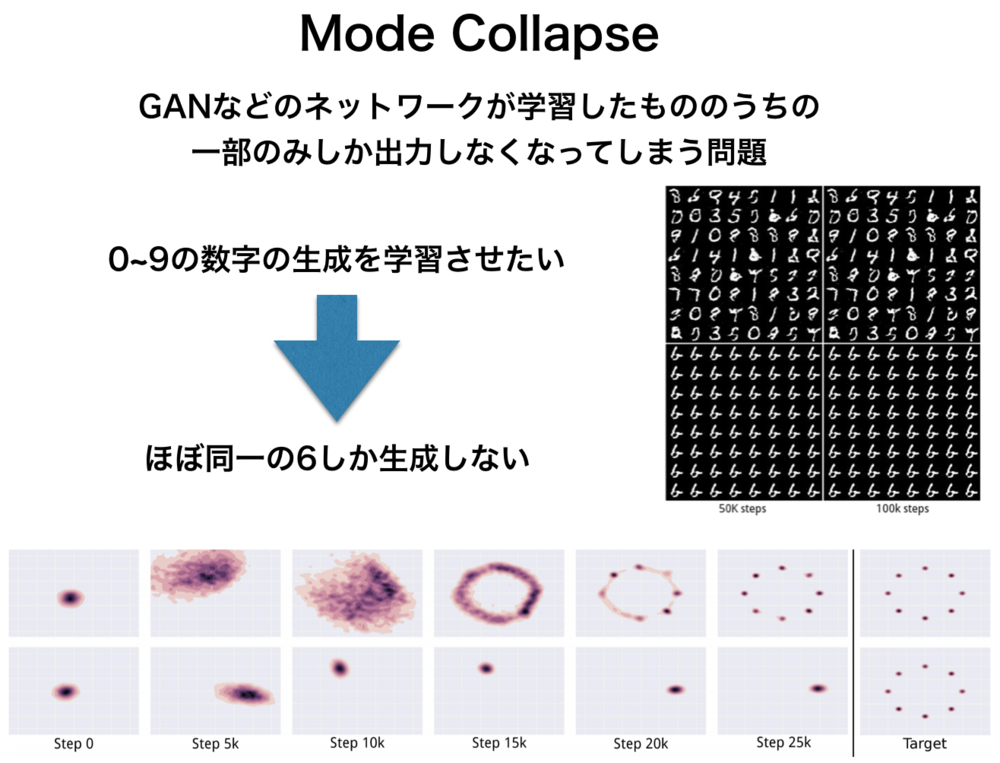

Mode Collapseとは

Mode Collapseとは、GAN等で主に問題となる数種類の結果のみを出力するようになってしまう問題のこと.例えば1から10までの数字の画像生成をさせようと学習しても6ばかり出すようになってしまう.

PV 684

Fav 0

2018.12.04

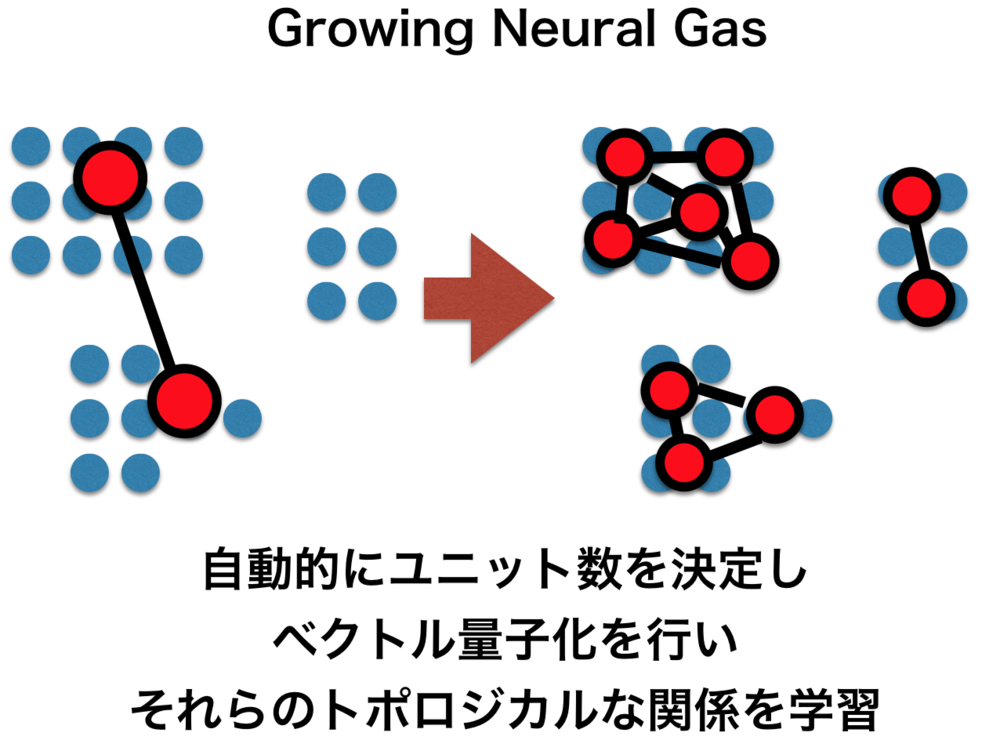

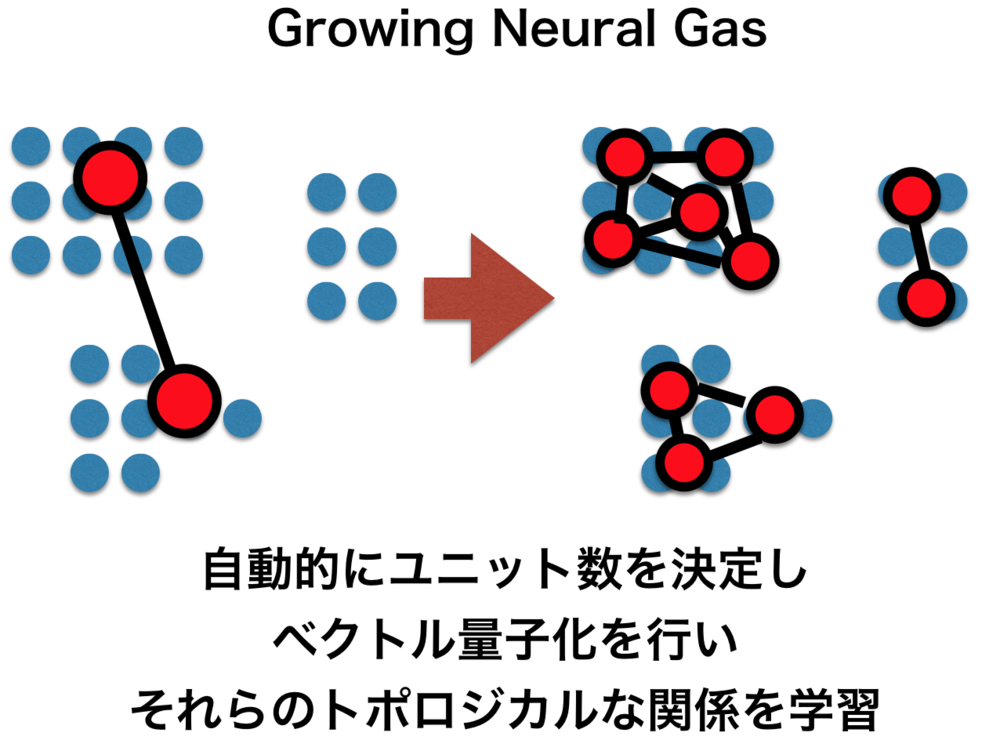

Growing Neural Gas

Growing Neural Gas(成長型ニューラルガス)とは、教師なしニューラルネットワークの一つで、Neural Gasが強く初期値に依存してしまうのを避け必要とあればネットワークを拡張するNeural Gasの一種.良い性能を発揮することで知られ、クラスタ分析においてはk-meansよりも優れていると言われる.

PV 427

Fav 0

2018.12.01

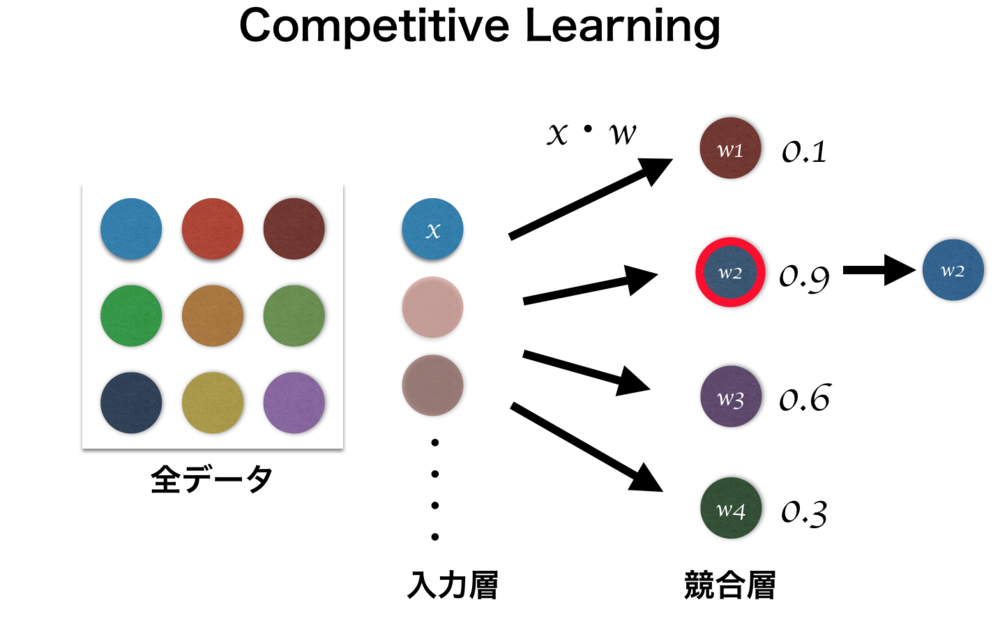

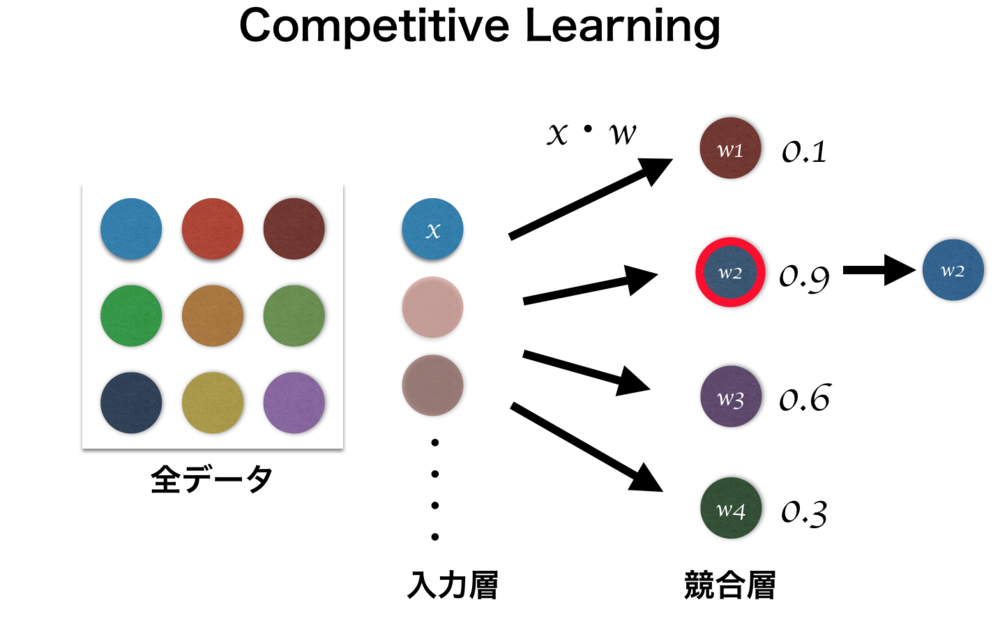

競合学習

競合学習(Competitive Learning)とは教師なし学習で頻繁に行われる学習で、最も入力データに反応したニューロンのみ更新したりするようなニューロン同士で競わせるような学習.winner-take-allな学習で勝者となったニューロンは入力データにより近くなるように更新する.自己組織化マップは競合学習の一つ.競合学習では入力層と競合層を持つ.

PV 635

Fav 0

2018.12.01

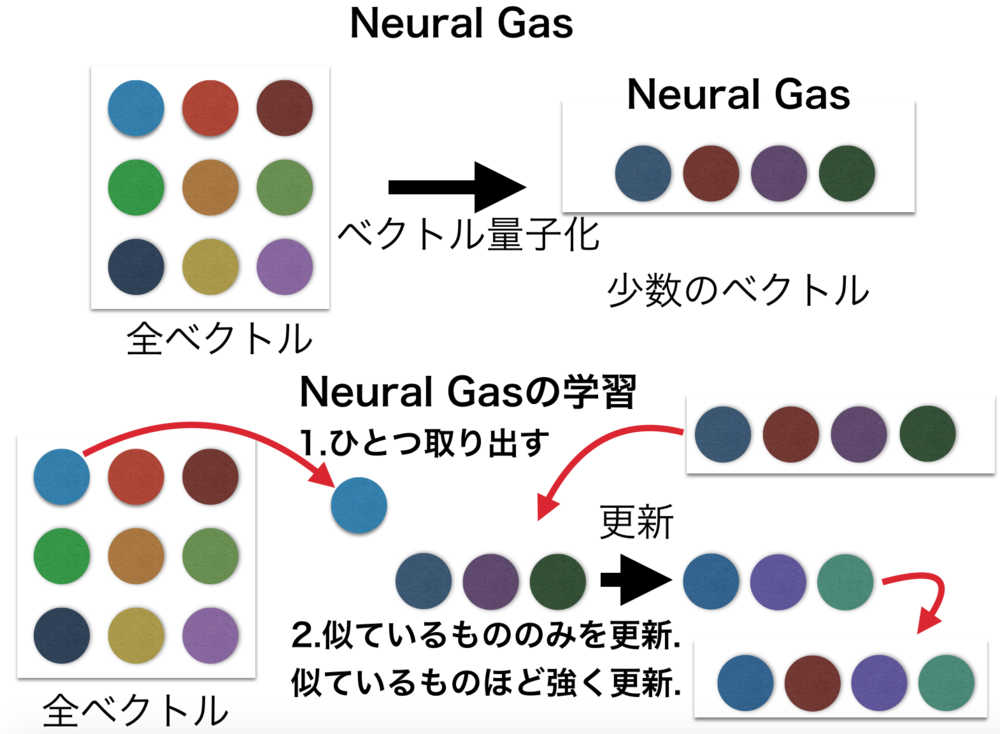

Neural Gas

Neural Gasは元々の多数の入力ベクトルデータを少数の特徴的なベクトルを用いて代用するベクトル量子化に利用されるニューラルネットワーク.

Neural Gasはよく自己組織化マップ(SOM)と比較されるが、自己組織化マップは学習時に隣接ベクトルとの制約があるのに対してNeural Gasはそれを持たない.

PV 213

Fav 0

2018.12.01

どうやったら時間軸データを学習させることができますか?

PV 152

Fav 0

2017.09.26

Deconvolution はUnpoolingやUpsamplingとは違いますか?

PV 134

Fav 0

2017.09.26

Deep Learningの最適化関数選定に関して

PV 91

Fav 0

2017.09.24

人工知能は現在どこまでできているのでしょうか?

PV 123

Fav 0

2017.09.24

ニューラルネットで二つの画像を入力にすることや途中でニューラルネットを混ぜることはできますか?

PV 138

Fav 0

2017.09.23

ニューラルネットで二つの画像を入力にすることや途中でニューラルネットを混ぜることはできますか?

PV 105

Fav 0

2017.09.23

簡単に画像を与えて分類することをやりたいです。

PV 96

Fav 0

2017.09.23

機械学習のpythonライブラリお薦め

PV 102

Fav 0

2017.09.22

ニューラルネットワークの翻訳への適用のしかたが分からない

PV 120

Fav 0

2017.09.22

おすすめのDeepLearningのネットワークはどれですか?

PV 119

Fav 0

2017.09.20

機械学習人気知識・質問

CTC損失関数

CTC Loss(損失関数) (Connectionist Temporal Classification)は、音声認識や時系列データにおいてよく用いられる損失関数で、最終層で出力される値から正解のデータ列になりうる確率を元に計算する損失関数.LSTMやRNNなどの出力を受けて正解文字列の確率を計算する.HMMのように前向き後ろ向きアルゴリズム、動的計画法を元に計算、微分可能であり誤差逆伝播が可能.

PV 1555

Fav 0

2018.12.08

Attention機構

Attention機構(注意機構)とは、主に機械翻訳や画像処理等を目的としたEncoder-Decoderモデルに導入される要素ごとの関係性、注意箇所を学習する機構.機械翻訳において翻訳対象の単語間の関係性や全体のコンテキストを考慮させるために考案されたものだが、画像処理などにおいても応用されている.

PV 1286

Fav 0

2018.12.08

PR曲線

PR曲線(Precision-Recall Curve)は、2クラスの分類の評価指標を与える曲線で、精度(Precision)と再現率(Recall)を軸にプロットしたグラフ.理想的な状態は右上に曲線が張り付く状態.大方ROC曲線と同じだが、ROC曲線より注目データに偏りがあって少ないデータしかないクラスがあるときに有用.

PV 1062

Fav 1

2019.02.07

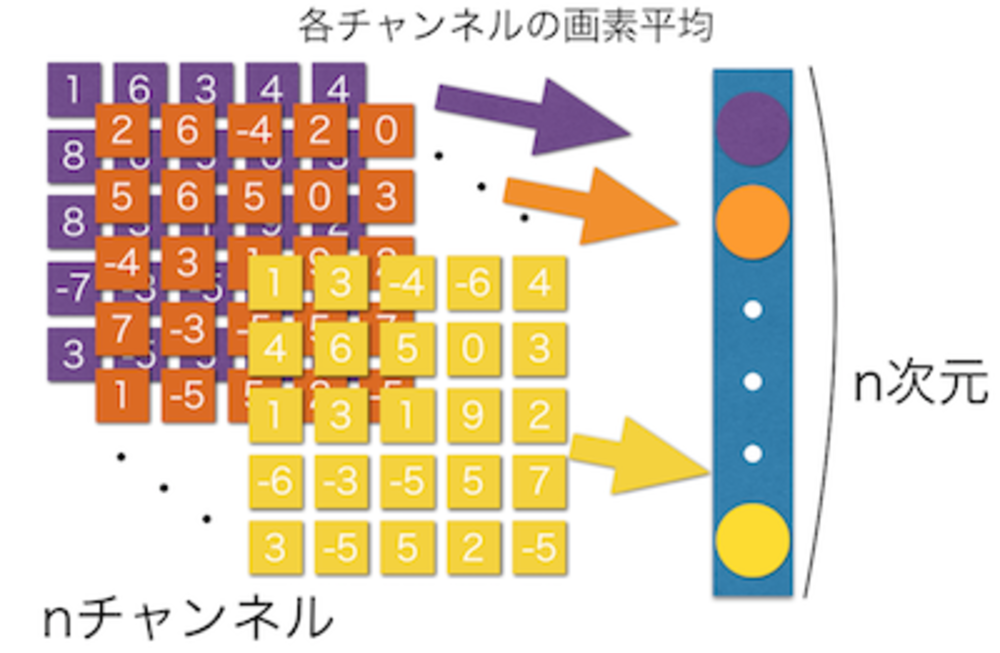

Global Average Pooling層

Global Average Pooling層によって最後の層において直接平均してクラスを作り出す。

PV 875

Fav 0

2017.09.18

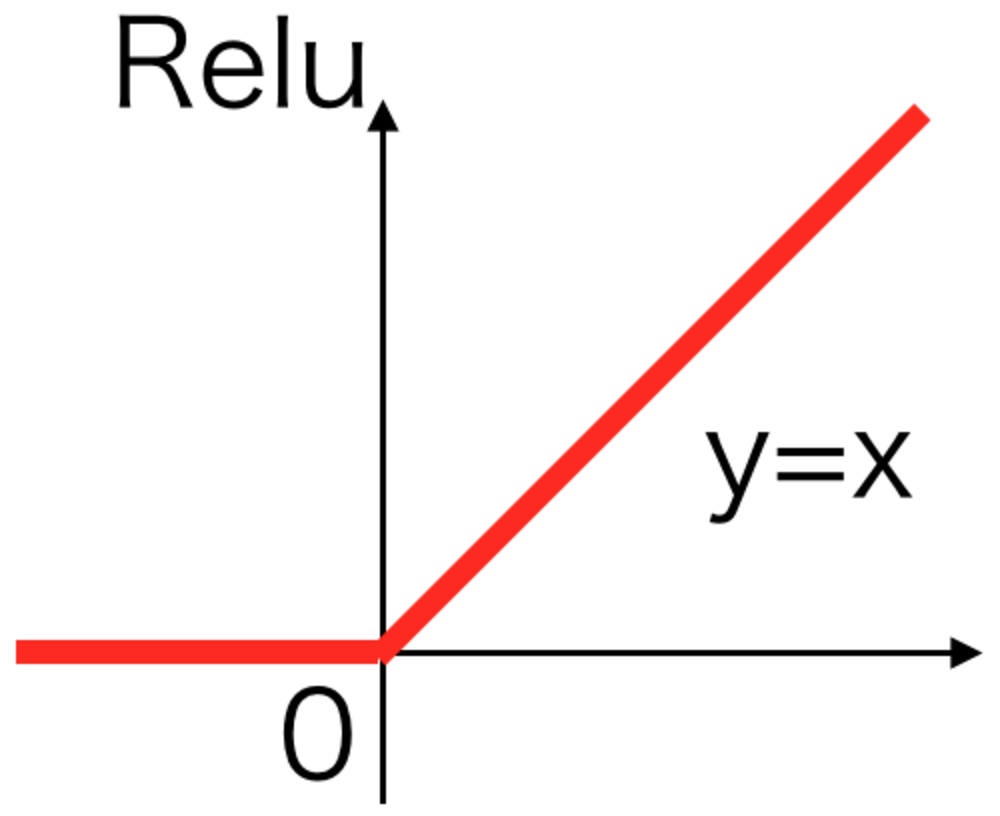

Relu活性化関数

最も現在使われることの多い活性化関数。

xが負のとき0それ以外は恒等関数.

シグモイドなどより計算が早いことが特徴.

PV 866

Fav 0

2017.09.13

ROC曲線

ROC曲線(受信者操作特性, Receiver Operating Characteristic)は、2クラスの分類の評価指標を与える曲線.もともとは信号処理の分野において用いられていたものだが、他分野でも使用されている.ある閾値を変えていく過程で再現率を縦軸、偽陽性率を横軸にプロットしたグラフ.曲線の下側の面積をAUC(Area Under Curve)と呼び、1に近いほどよく、曲線は左上に張り付いている方がよい.

PV 753

Fav 0

2019.01.29

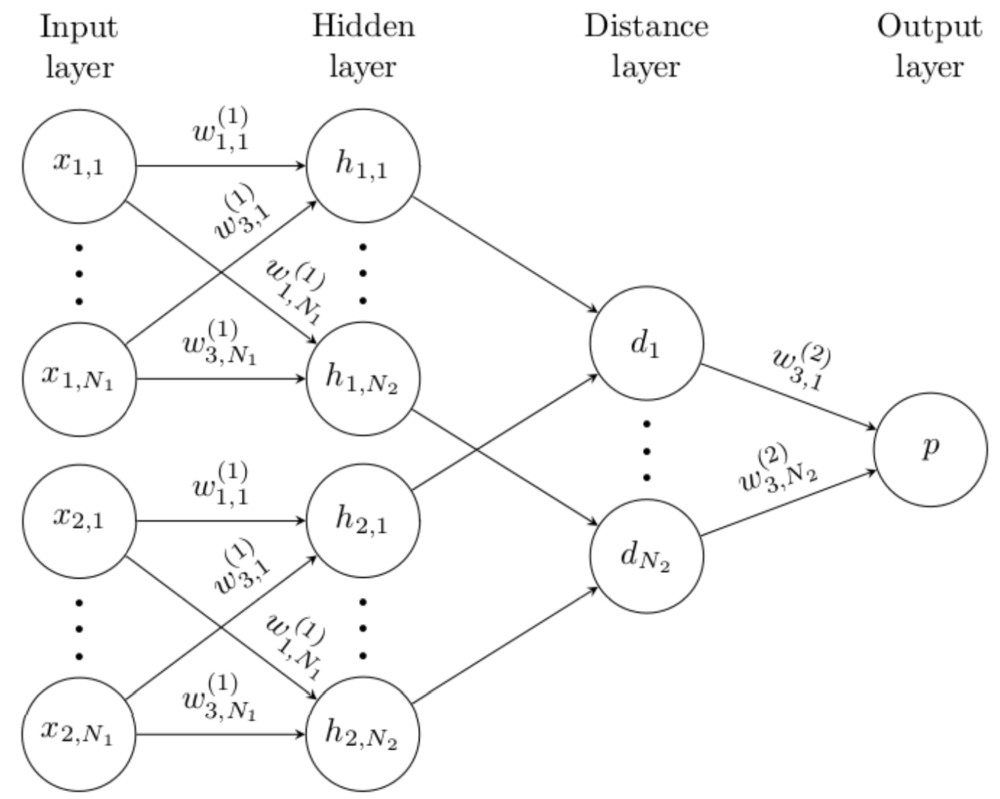

シャムネットワーク

シャムネットワークは(Siamese Network)二つの画像の似ている似ていないという指標となる距離を学習するCNNを利用したニューラルネットワーク.二つのCNNは重みが共有されていてそれらの出力を距離を計算するネットワークに入力する.

PV 727

Fav 0

2018.07.15

Mode Collapseとは

Mode Collapseとは、GAN等で主に問題となる数種類の結果のみを出力するようになってしまう問題のこと.例えば1から10までの数字の画像生成をさせようと学習しても6ばかり出すようになってしまう.

PV 684

Fav 0

2018.12.04

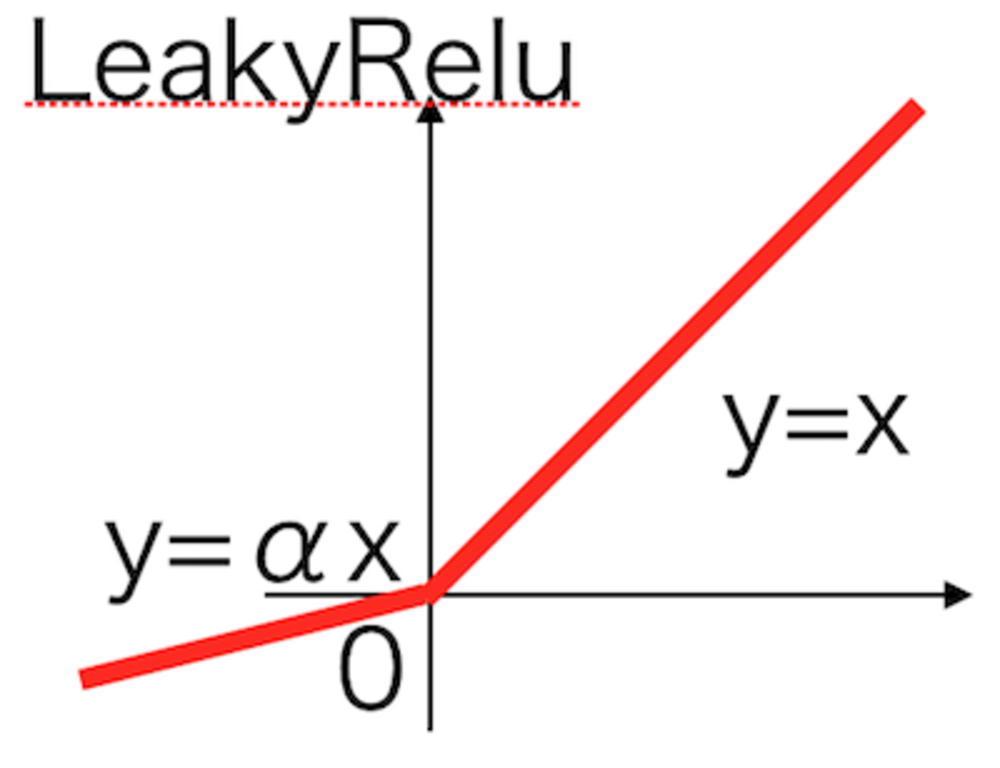

LeakyRelu活性化関数

Reluでxが負の場合を改良したLeakyRelu活性化関数.

PV 681

Fav 0

2017.09.13

競合学習

競合学習(Competitive Learning)とは教師なし学習で頻繁に行われる学習で、最も入力データに反応したニューロンのみ更新したりするようなニューロン同士で競わせるような学習.winner-take-allな学習で勝者となったニューロンは入力データにより近くなるように更新する.自己組織化マップは競合学習の一つ.競合学習では入力層と競合層を持つ.

PV 635

Fav 0

2018.12.01

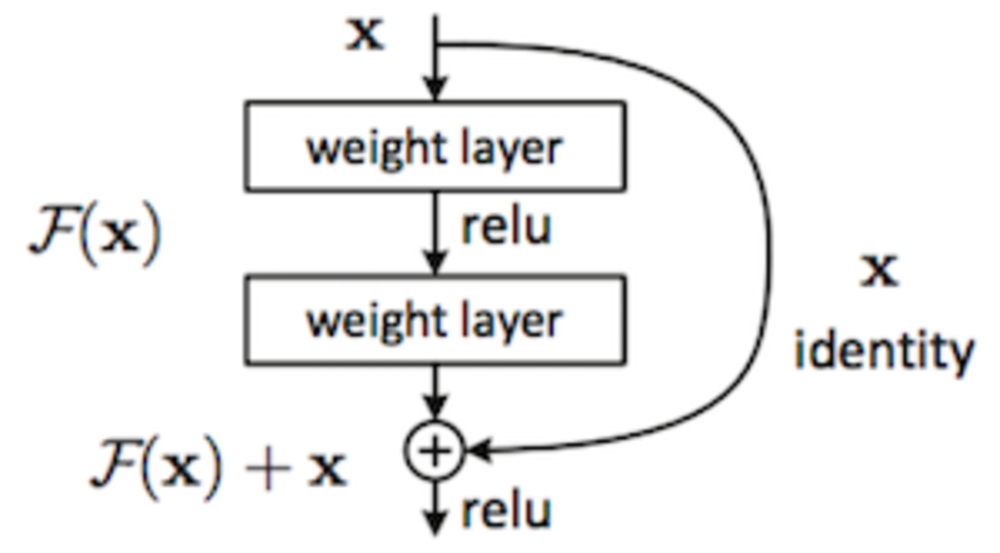

ResNetとは

ResNetは2015年にMicrosoftより発表された152層からなるニューラルネットワーク.

今まで20層ほどで作られていたCNNを特別なユニットを挟むことで深くすることを可能にした.

PV 613

Fav 0

2017.09.13

単純ベイズ分類器

単純ベイズ分類器(ナイーブベイズ)は、特徴間は全て独立という強引な前提を置き、ベイズの定理を使用することで、特徴量を入力にクラスを分類する分類器.単純で実装も容易ではあるが、一部のアプリケーションで十分に働く.メールのスパム分類で使用されたことで有名.

PV 608

Fav 0

2019.03.04

CNNで画像内文字列をOCR

CNNを使って画像の文字列を認識してプログラムで扱える文字列に起こすOCRの例について紹介します.文字列が可変の場合に対応したCNN+LSTMで構成される基本的なネットワークです.

PV 588

Fav 0

2018.12.06

Adam最適化関数

学習係数を自動で調整させる最適化関数の一つ.

Adagrad, RMSPropを改良し移動平均を付け加えた最適化関数.

PV 564

Fav 0

2017.09.13

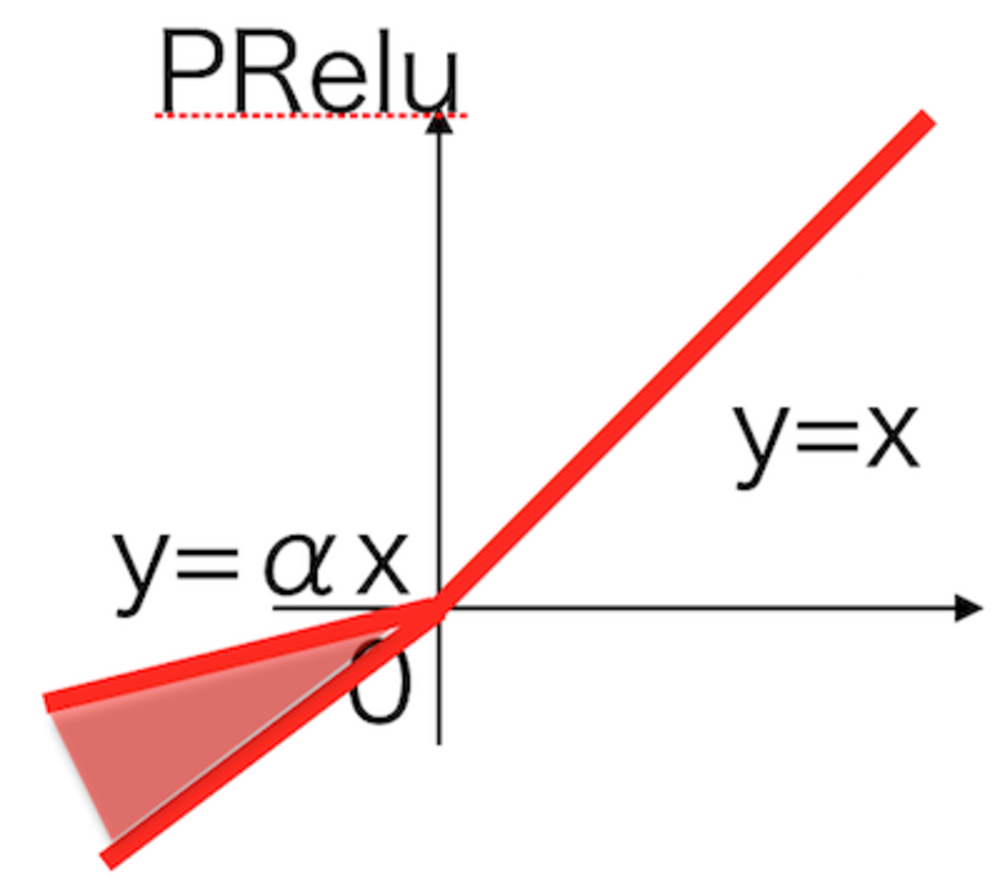

PRelu活性化関数

LeakyReluを改良して、学習しながら適切な傾きを変更していく.

PRelu活性化関数.

PV 533

Fav 0

2017.09.13

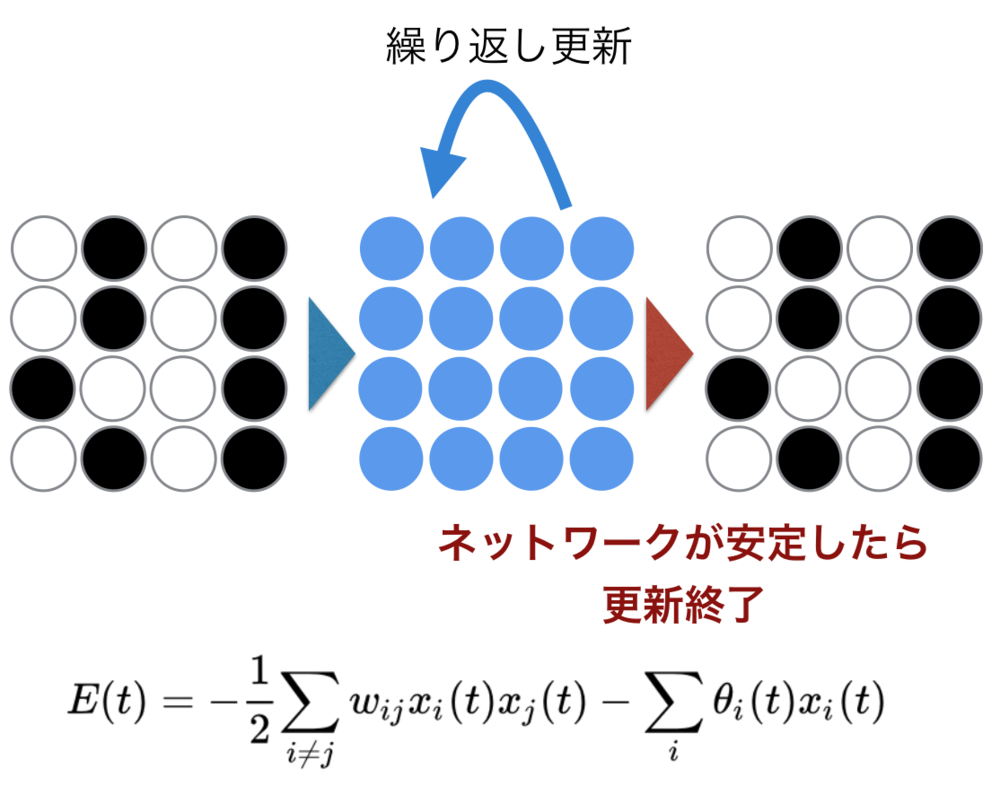

ホップフィールドネットワーク

ホップフィールドネットワークは、ニューラルネットワークの火付け役となった、記憶や想起が可能なネットワークである.想起をするときはエネルギ関数を使用して複数回処理を行い、ネットワークが安定したと判定されたときに出力する.

PV 490

Fav 0

2018.08.08

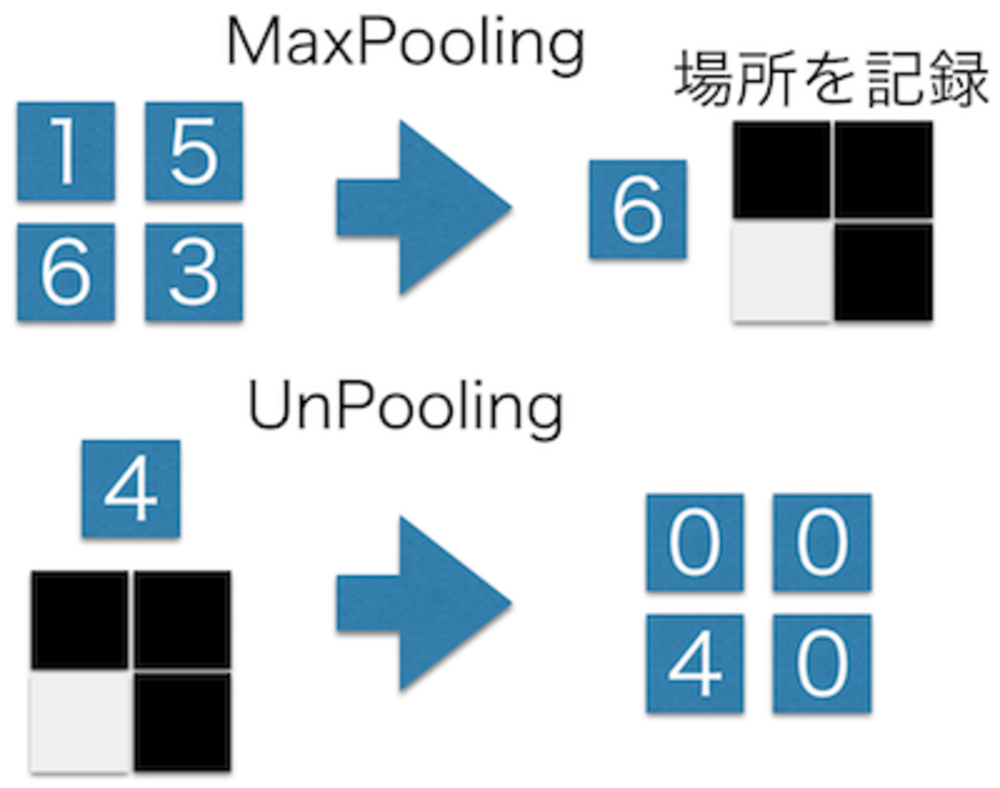

UnPooling層

Convolutional AutoEncoder(CAE)などで用いられるMaxPoolingの反対の動き(画素を拡大する)をする層

PV 458

Fav 0

2017.09.13

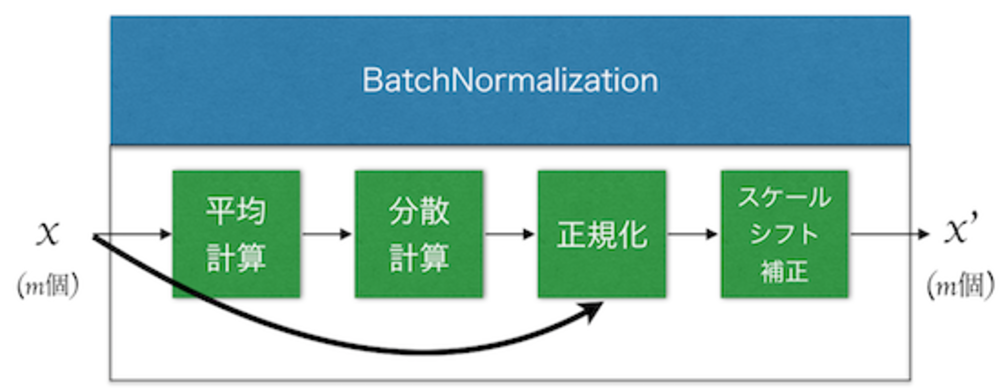

Batch Normalization層

Batch Normalization層は近年提案されるどのネットワークにも大体使用される学習を安定させ高速化させる技術. ミニバッチごとの平均と分散を計算して正規化し、スケールとシフト補正をする.

PV 441

Fav 0

2017.09.13

Adagrad最適化関数

学習係数を自動調整していく最適化関数の一つ.

過去の勾配と最新の勾配を元に各パラメータごとに学習率を調整するのが特徴.

Adam, Adadelta, RMSPropはAdagradを改良したもの

PV 436

Fav 0

2017.09.13

Growing Neural Gas

Growing Neural Gas(成長型ニューラルガス)とは、教師なしニューラルネットワークの一つで、Neural Gasが強く初期値に依存してしまうのを避け必要とあればネットワークを拡張するNeural Gasの一種.良い性能を発揮することで知られ、クラスタ分析においてはk-meansよりも優れていると言われる.

PV 427

Fav 0

2018.12.01

どうやったら時間軸データを学習させることができますか?

PV 152

Fav 0

2017.09.26

ニューラルネットで二つの画像を入力にすることや途中でニューラルネットを混ぜることはできますか?

PV 138

Fav 0

2017.09.23

Deconvolution はUnpoolingやUpsamplingとは違いますか?

PV 134

Fav 0

2017.09.26

人工知能は現在どこまでできているのでしょうか?

PV 123

Fav 0

2017.09.24

ニューラルネットワークの翻訳への適用のしかたが分からない

PV 120

Fav 0

2017.09.22

おすすめのDeepLearningのネットワークはどれですか?

PV 119

Fav 0

2017.09.20

ニューラルネットで二つの画像を入力にすることや途中でニューラルネットを混ぜることはできますか?

PV 105

Fav 0

2017.09.23

機械学習のpythonライブラリお薦め

PV 102

Fav 0

2017.09.22

簡単に画像を与えて分類することをやりたいです。

PV 96

Fav 0

2017.09.23

Deep Learningの最適化関数選定に関して

PV 91

Fav 0

2017.09.24