この章を学ぶ前に必要な知識

効果

- x が負でも勾配を持つので、学習が進みやすい

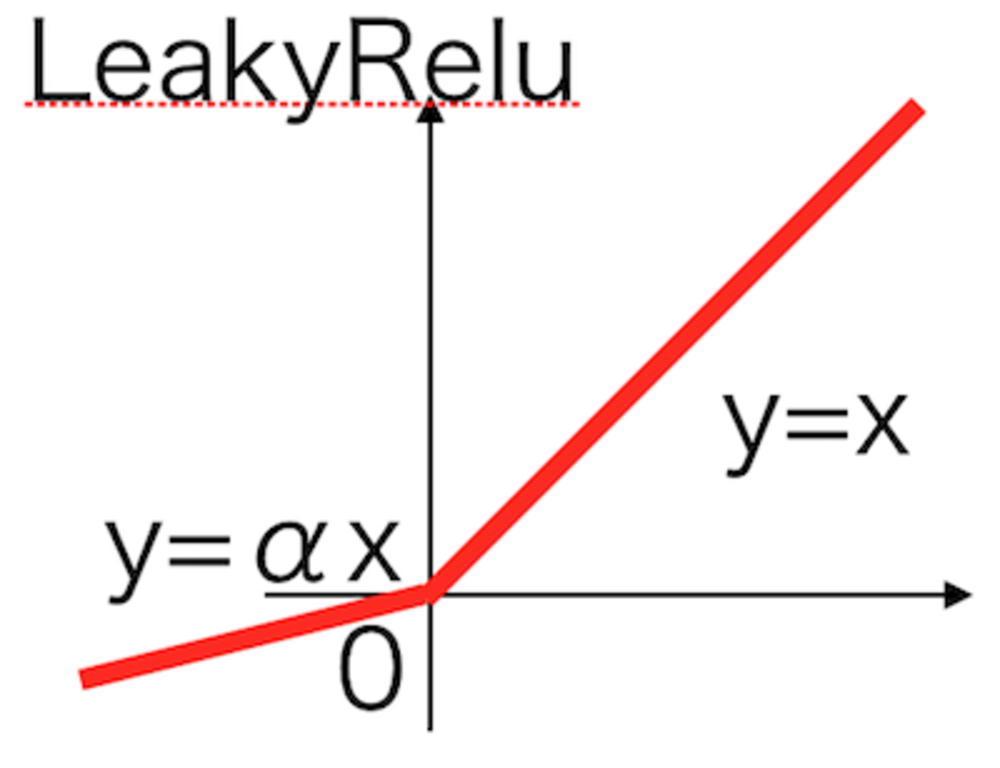

ポイント

- Reluをベースに改良

- 負のときのy=αxのαはあらかじめ学習前に人が設定し不変

- Reluで発生するdying Relu問題を負でも勾配をもたせることで解消

解 説

ReluをベースにReluでneuronがどの入力を受けても同じ値を返すdead neuron問題を解決するために改良が加えられた活性化関数.

xが負の時も僅かな傾きをもたせることで学習が止まってしまうことを防いでいる.

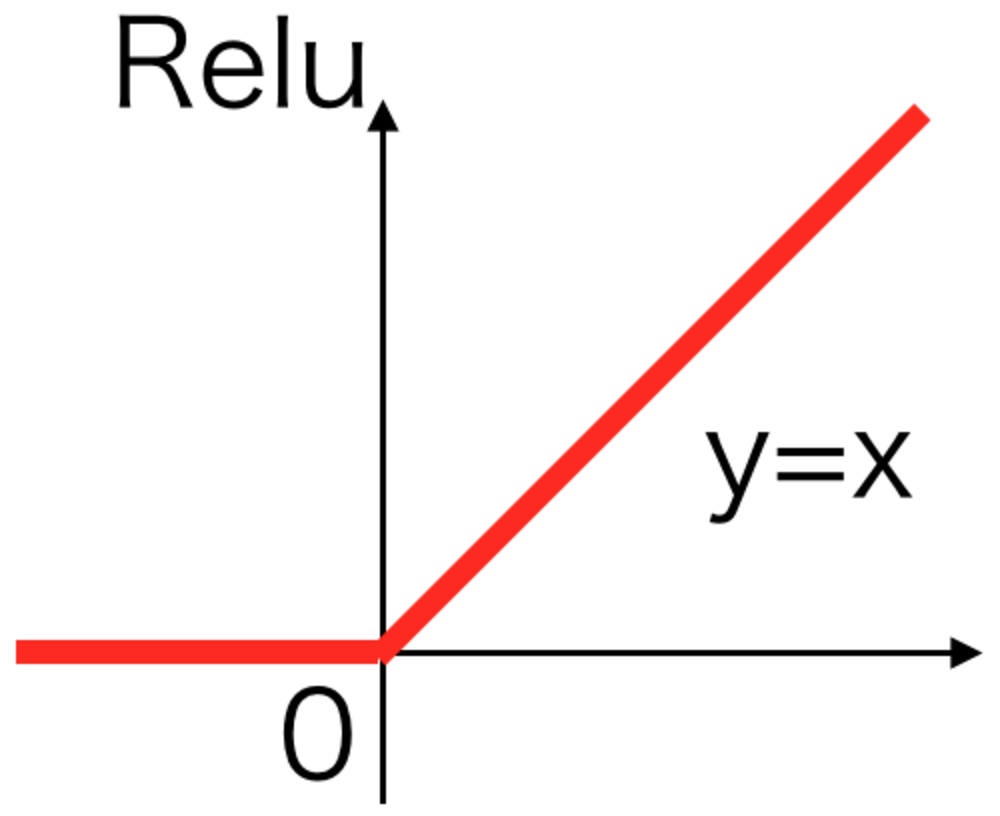

ただし、これによってあらかじめ調整するハイパーパラメータが一つ増えてしまう点があえて言うなら欠点. | Relu活性化関数 |

\begin{eqnarray}

y

=

\begin{cases}

x & ( x \geqq 0 ) \\

\alpha x & ( x \lt 0 )

\end{cases}

\end{eqnarray} | LeakyRelu活性化関数

αは通常かなり小さい値が設定される |

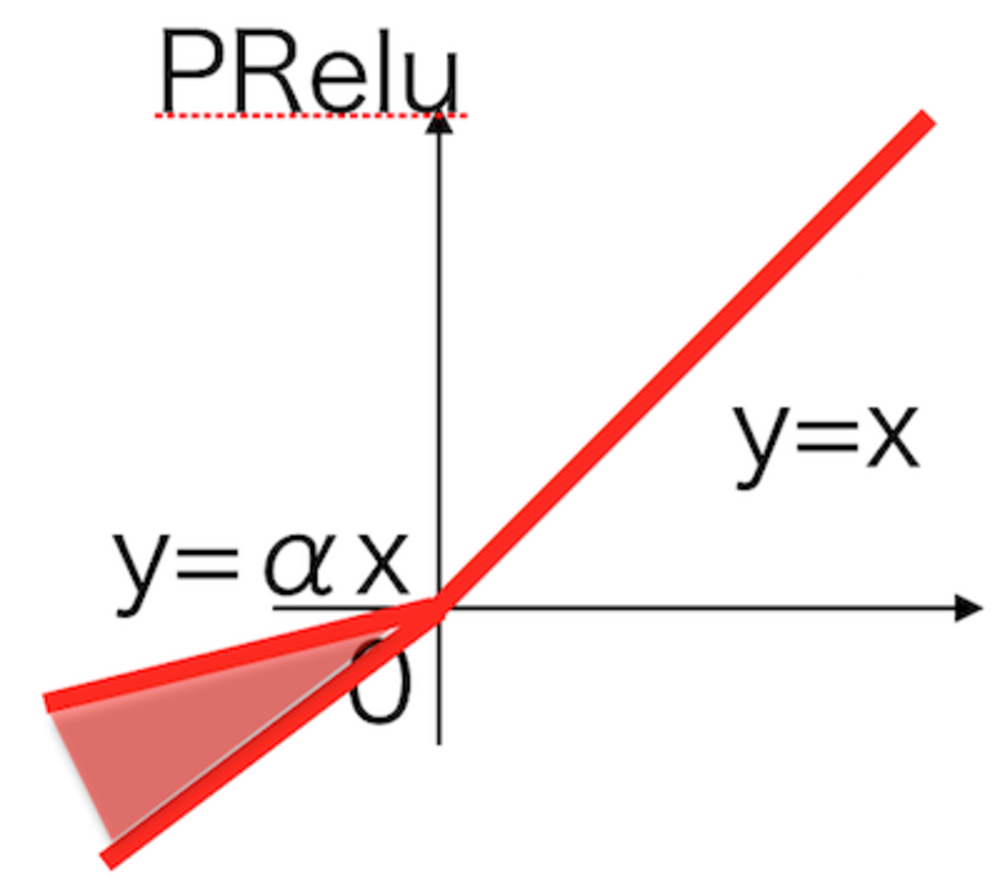

αがハイパーパラメータになってしまったのを改良し、

αも学習するPReluというものも提唱されていて、

場合によっては精度が向上するとも言われている。 | PRelu活性化関数 |

この章を学んで新たに学べる

Comments

@ThothChildren

@ThothChildren